Страница 200 - гдз по алгебре 11 класс учебник Мерзляк, Номировский

Авторы: Мерзляк А. Г., Номировский Д. А., Полонский В. Б., Якир М. С.

Тип: Учебник

Издательство: Просвещение

Год издания: 2016 - 2026

Уровень обучения: базовый

Цвет обложки: синий, зелёный

Допущено Министерством просвещения Российской Федерации

Математика. Алгебра и начала математического анализа

Популярные ГДЗ в 11 классе

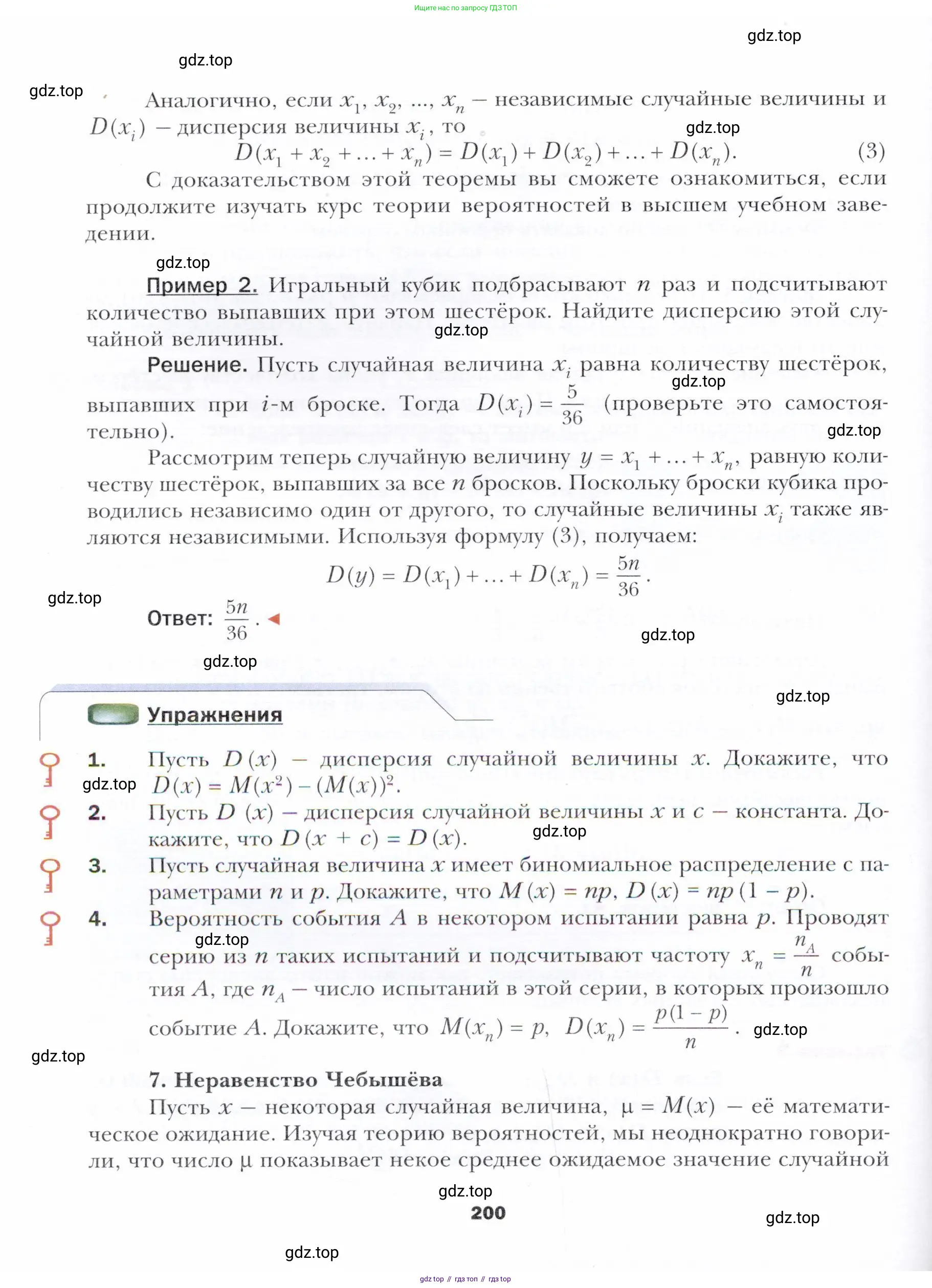

Cтраница 200

Другие страницы:

Помогло решение? Оставьте отзыв в комментариях ниже.